在WSL上部署Hadoop

今天上午在VLC的官网上看到一个叫VLMC的尚未发布的项目,是非线性视频编辑软件,具体介绍见官网。于是就想折腾一下,马上把源码clone下来想要编译,可是Windows少太多东西,一番瞎搞后,编译任务最终还是以失败告终。但是突然想起Windows的WSL是真香产品,便立即放弃编译,开始永无止境的折腾之路,然后就有了今天上午三个小时的安装Hadoop过程。

主要安装步骤参考CSDN上的教程这里就不多做赘述,谈一下我遇到的几个问题:

-

使用SSH连接本地时遇到拒绝连接

Connection Refused的情况,是因为在WSL中启动ssh服务需要root权限,所以导致ssh服务启动失败,执行以下命令即可启动ssh连接本地:sudo service ssh start。 -

在安装并配置好Hadoop后,在执行

./sbin/start-dfs.sh时出现localhost: sleep: cannot read realtime clock: Invalid argument报错。Google之后找到答案,原来是WSL Ubuntu的问题,输入以下命令即可解决:sudo mv /bin/sleep /bin/sleep~ touch /bin/sleep chmod +x /bin/sleep

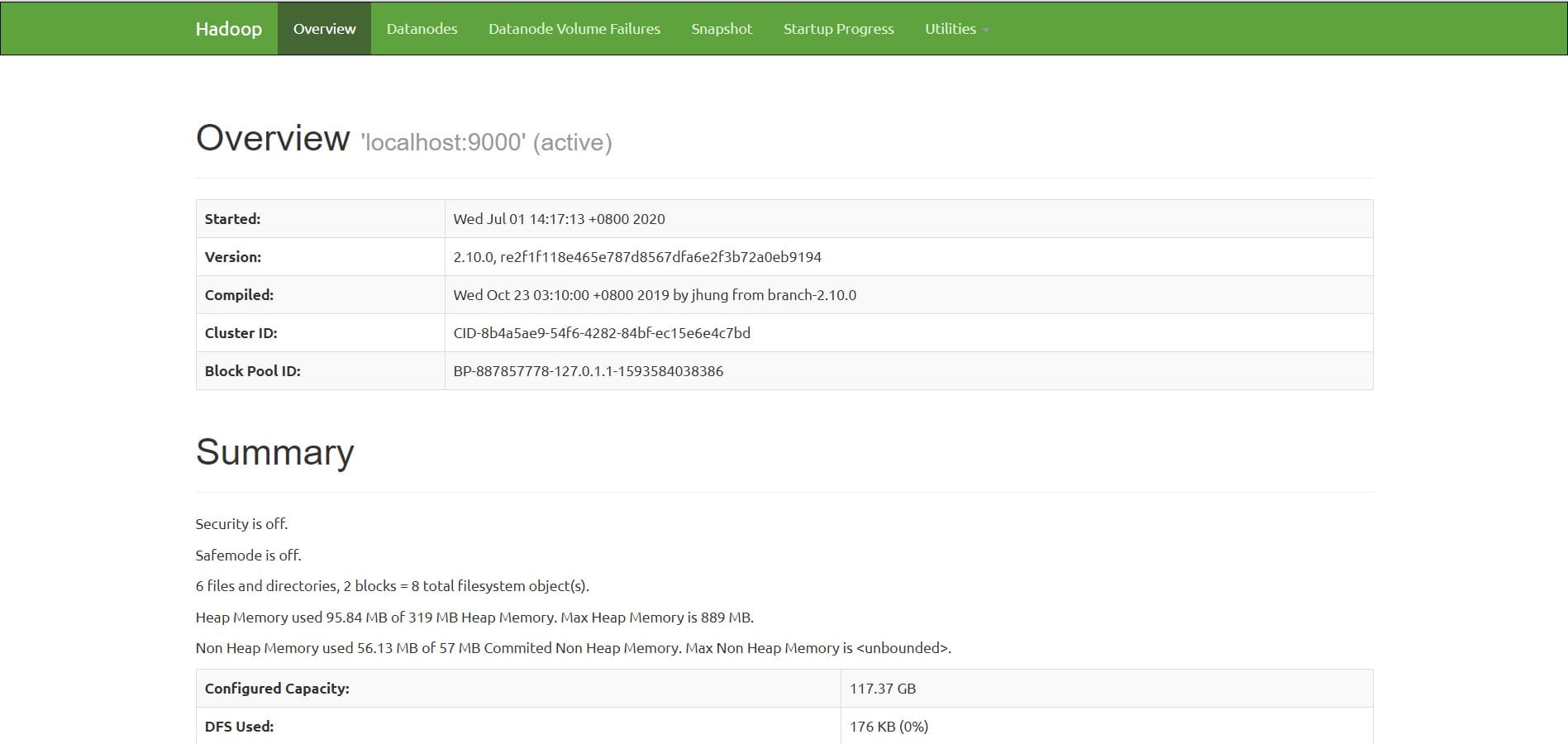

解决以上问题后浏览器输入localhost:50070即可访问Hadoop,如下图所示:

安装完成之后可以运行一个wordcount示例进行测试,如果成功就证明Hadoop安装完成,下面就可以自己写任务了。

以上即为今天的WSL安装Hadoop的实践过程。